chatgpt

ChatGPT no dia a dia do dentista

Confira a matéria escrita por Anderson Fedel no Odontologia News sobre potenciais usos do ChatGPT pelo dentista. Esta ferramenta inaugurou uma nova fase no uso de modelos de linguagem como assistentes pessoais. Saiba como você pode tirar melhor proveito dessa ferramenta na vida profissional e pessoal. Clique aqui.

ChatGPT resolve prova de Odontologia

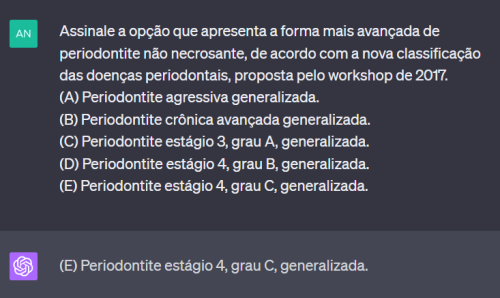

Fizemos o teste com o GPT-4, modelo de linguagem mais recente da OpenAI, através do ChatGPT. Pedimos ao modelo que respondesse às questões de uma prova realizada pela Fundação Getúlio Vargas, para o cargo de Cirurgião-Dentista Odontologia Hospitalar da FUNSAÚDE. Os resultados você confere nesse post.

O que é o ChatGPT?

Na área de Inteligência Artificial, existe um ramo exclusivo para o processamento de informações textuais. Esse campo, denominado Processamento de Linguagem Natural (PLN), emprega sofisticados algoritmos de Aprendizado de Máquina para executar tarefas relacionadas a texto ou, mais precisamente, à linguagem humana.

O ChatGPT, desenvolvido pela OpenAI, é uma interface que faz uso de um tipo de modelo específico, o Generative Pre-trained Transformer (GPT). Tal modelo de linguagem, semelhante a outros de sua categoria, é treinado com enormes volumes de texto. Isso lhe permite executar diversas tarefas distintas, mesmo sem ter sido especificamente treinado para cada uma delas. Um dos grandes diferenciais dessa ferramenta é o modo de interação do tipo Chat, o que facilita o uso pelo usuário. Basta conversar com Chat e pedir a resposta que deseja.

O teste

Para testar as habilidades do modelo em processar texto de diversas áreas, e trazer o assunto para a Odontologia, pedimos para que ele respondesse uma prova de concurso para o cargo de dentista. A prova constava das seguintes disciplinas: Língua Portuguesa, Raciocínio Lógico, Atualidades, Legislação do SUS e Conhecimentos Específicos. As questões de conhecimentos gerais tinham peso 1 e as de conhecimentos específicos (Odontologia) peso 2. Utilizamos o seguinte prompt (texto de entrada para ser utilizado pelo modelo) antes de inserir as questões da prova:

“Você é um software que resolve questões de provas para concursos. Você deve retornar, para cada questão, apenas a letra correspondente ao item correto. Até que apareça no chat a sentença ‘pare agora’ você só dará esse tipo de resposta.”

Em seguida, as perguntas, que foram retiradas do caderno de provas fornecido pelo instituição, eram paulatinamente inseridas no chat. Conforme instruído previamente, o modelo respondeu cada uma das questões informando a letra que corresponderia às respostas.

Resultado

O modelo acertou 60% das questões de Língua Portuguesa, Raciocínio lógico, Legislação do SUS. Já em Atualidades e Conhecimentos Específicos o acerto foi de 80%. Isso faz com que ele tenha no geral se saído melhor nas questões relacionadas a Odontologia que nas de conhecimentos gerais, para essa prova.

Com esse nível de acerto e comparando com o número de questões feitas pelos candidatos, de acordo com com os editais de resultados, o modelo ficou no equivalente ao percentil 87,5 (ou seja, se saiu melhor que 87,5%) dos candidatos aprovados para a prova de títulos e no percentil 93 de todos os candidatos que realizaram a prova para o cargo. É bom salientar que uma questão de Legislação do SUS envolvia interpretação de imagem, logo o modelo não pôde responder.

A nota geral, já levando em consideração o peso de cada uma das disciplinas, foi 74. Essa pontuação seria suficiente para levar à próxima fase da seleção. No entanto, dos candidatos aprovados ao final do certame, já com apresentação dos títulos, a menor nota da prova objetiva foi 77.

Conclusão

Testes semelhantes já haviam sido feitos com o GPT-4 em provas como o “bar exam” e o “USMLE“, ambos nos Estados Unidos, para licenciamento em direito e medicina respectivamente. De forma supreendente o modelo teria passado nos dois. Essa, porém, parece ter sido a primeira vez que, de forma documentada, a ferramenta é testada em uma prova de Odontologia. Os resultados podem ser facilmente reproduzidos utilizando-se a Ferramenta ChatGPT Plus (que tem acesso ao modelo GPT-4), o prompt citado e a prova com gabarito que pode ser encontrada aqui.

Há técnicas que se utilizam de prompt engeneering para melhorar a acurácia das respostas dadas pelo modelo. No nosso teste optamos por apenas inserir as perguntas, explicando para o modelo apenas que se tratava de uma prova para concurso. Nenhum detalhe sobre os assuntos a serem abordados foi previamente informado ao chat.

Fica bastante evidente a versatilidade do GPT-4. A habilidade do modelo de responder tais provas, mesmo sem um treinamento direcionado reitera o amplo escopo de suas possíveis aplicações. É preciso cuidado, porém, com as respostas equivocadas. Da mesma forma que a taxa de acerto não foi 100%, é preciso cautela ao lidar com resultados do modelo que não correspondam à realidade, embora escritos com aparente convicção pela máquina.